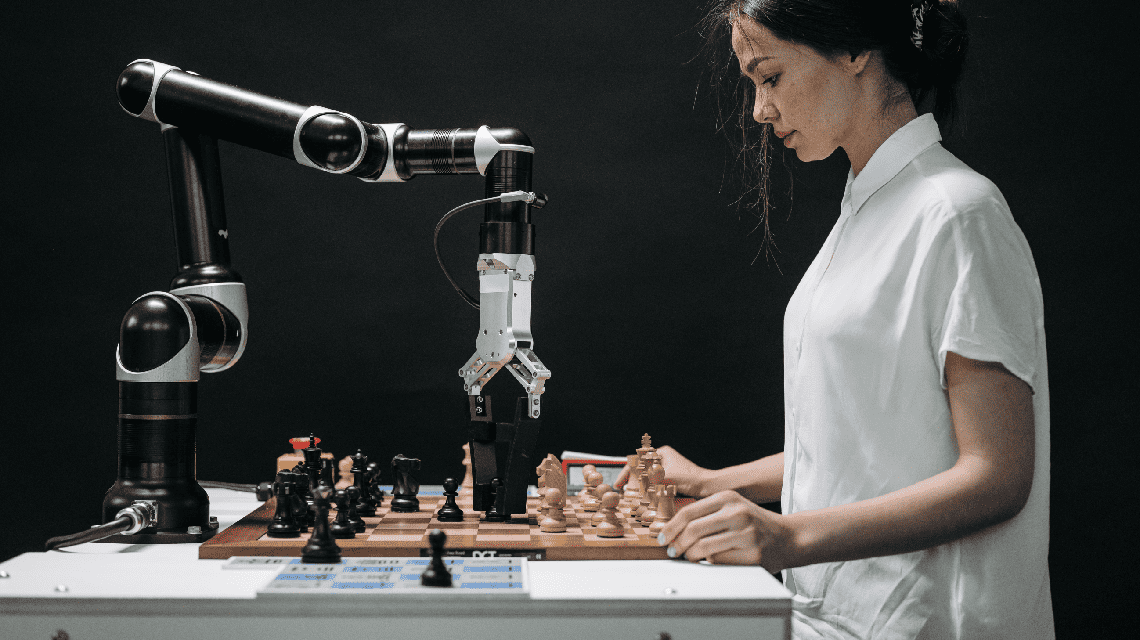

Pablo Pruneda y Pedro Salazar discuten en este texto sobre el desarrollo de la Inteligencia Artificial y su posible impacto en la vida democrática.

Pablo Pruneda y Pedro Salazar discuten en este texto sobre el desarrollo de la Inteligencia Artificial y su posible impacto en la vida democrática.

Texto de Pablo Pruneda Gross & Pedro Salazar Ugarte 07/06/23

Pablo Pruneda y Pedro Salazar discuten en este texto sobre el desarrollo de la Inteligencia Artificial y su posible impacto en la vida democrática.

La irrupción de la inteligencia artificial en nuestras vidas se ha vuelto cotidiana y ha llegado para quedarse. De hecho, no hay día en que no utilicemos alguna de sus aplicaciones para resolver o mejorar alguna tarea en concreto. Gracias a ella, por ejemplo, predecimos el clima y encontramos la ruta más rápida para llegar a nuestro destino. Con celeridad pasamos del asombro a la normalización. Y estamos a la expectativa de las aplicaciones que están por llegar.

Apenas a finales del año pasado, una nueva manifestación de la inteligencia artificial se hizo pública y se convirtió en un verdadero parteaguas entre lo real y lo posible. La empresa OpenAI liberó al público la versión 3.5 de su GPT (“Transformador Preentrenado Generativo”, en su traducción al español) a través de una interface que nos permite interactuar con esta herramienta a modo de chat. Esta aplicación, conocida comercialmente como “ChatGPT”, llegó a nuestras vidas para mostrarnos, de manera aún más contundente, los impresionantes alcances de una rama de la inteligencia artificial conocida como generative AI (“IA generativa”). Su principal característica es su asombrosa capacidad para crear textos, códigos, imágenes y videos a partir del acceso y procesamiento de una enorme cantidad de datos. Al usar por primera vez estas herramientas nos atrapa una especie de déjà vu que nos recuerda la primera vez que accedimos a internet.

“A un par de meses de su liberación al público, ChatGPT alcanzó 100 millones de usuarios activos, lo que la convirtió en la app de consumo con el más rápido crecimiento de la historia.”

A un par de meses de su liberación al público, ChatGPT alcanzó 100 millones de usuarios activos, lo que la convirtió en la app de consumo con el más rápido crecimiento de la historia. Para ponerlo en contexto: Facebook tardó 10 meses en lograr un millón de usuarios; al ChatGPT le tomó cinco días.

Al percatarse de la enorme potencialidad de esta inteligencia artificial, Microsoft anunció a principios de este año que incrementaría en 10 mil millones de dólares su inversión a OpenAI. Una cifra ingente e inusitada. Esto tuvo un fuerte impacto en el sector. El principal competidor de OpenAI, Google, se dio cuenta de que ChatGPT ponía en riesgo su principal fuente de ingresos: la venta de publicidad en su buscador. Eso es cierto porque con este tipo de aplicaciones podría cambiar de manera drástica la manera en la que nos relacionamos con la información en internet.

La situación no deja de ser paradójica porque Google, desde el 2017, desarrolló el primer modelo de procesamiento de lenguaje natural a partir de la arquitectura Transformer, pero no liberó ninguna versión al público debido a que el informe de evaluación de riesgos sobre el uso de estas herramientas no fue positivo. Sin embargo, al percatarse de que OpenAI se encontraba trabajando en la nueva versión GPT-4 —mucho más poderosa que GPT-3.5—, Google decidió hacer lo propio y anunció el lanzamiento de BARD, la versión más avanzada de su large language model (“modelo de lenguaje a gran escala”). Así, la lógica del mercado desplazó el semáforo de riesgos.

En marzo de este año, cuando OpenAI anunciaba la salida al público de GPT-4, Google lanzó un video promocional sobre el funcionamiento de BARD. Parecía la reacción adecuada, pero no lo fue. Al responder las preguntas que se le planteaban, la herramienta falló y dio una respuesta falsa. Los mercados no perdonan y sancionaron la pifia con la caída de las acciones de Alphabet (la matriz de Google) en más de 100 mil millones de dólares.

El entuerto dejó al descubierto uno de los problemas y peligros iniciales de esta manifestación de la IA generativa: su propensión a cometer errores (lo cual se conoce como “alucinar”). Pero GPT-4 redujo de manera significativa las alucinaciones o respuestas erróneas. Una manera de medirlo —y también de captar el impacto que podría tener en las profesiones y los trabajos de los seres humanos— son los resultados de exámenes académicos. Por ejemplo, en el examen único de la barra de abogados de los EE. UU., GPT-3.5 logró un porcentaje de aprobación del 10% mientras que GPT-4 alcanzó un asombroso 90%.

Esta mejora sustancial en la capacidad de GPT-4 ha generado muchas reacciones. El 22 de marzo pasado, el Future of Life Institute hizo pública una carta firmada por más de mil expertos, donde se hacía un llamado a los laboratorios de inteligencia artificial para que detuvieran durante 6 meses cualquier desarrollo de sistemas con capacidad mayor a la de GPT-4. Entre los firmantes están los nombres de Yoshua Bengio, Stuart Russell, Elon Musk, Yuval Noah Harari y Max Tegmark.

“[…] en el examen único de la barra de abogados de los EE. UU., GPT-3.5 logró un porcentaje de aprobación del 10% mientras que GPT-4 alcanzó un asombroso 90%.”

Ese mismo día, Microsoft publicó un estudio preliminar sobre GPT-4 en el que lo calificó como una incipiente, aunque incompleta versión de un sistema de “Inteligencia General Artificial” (AGI, por sus siglas en inglés); esto se refiere a una forma de inteligencia artificial que eventualmente lograría realizar cualquier tarea intelectual al igual que un ser humano. Lo anterior lo concluyeron a partir de observar que ciertas de sus respuestas eran verdaderos chispazos de inteligencia similar a la nuestra.

La vorágine de hechos y declaraciones no se ha detenido. Hace pocas semanas, uno de los “padrinos de la inteligencia artificial”, el respetado Dr. Geoffrey Hinton, anunció su salida de Google luego de 20 años de trabajar para esa empresa. Lo hizo, según informó, para poder alzar la voz con absoluta libertad sobre los riesgos que esta nueva forma de inteligencia artificial representa. Es decir, decidió alertar sobre sus peligros y hacer un llamado para enfrentarlos.

Su principal advertencia fue que las inteligencias digitales de nuestras computadoras están aprendiendo más y mejor que los seres humanos con su cerebro. Citó algunos ejemplos concretos que cambiaron su visión sobre los alcances de la inteligencia artificial. Por ejemplo, detectó que PaLM (un chatbot de Google) había superado una prueba que él mismo había diseñado para determinar si un sistema poseía inteligencia con entendimiento de la realidad. La prueba da escalofríos: el sistema logró explicar en qué consistía la gracia de unos chistes que le fueron presentados.

También le preocupó que ChatGPT tenga una capacidad para aprender mucho mayor que la nuestra y sea mucho más eficiente que nuestro cerebro. Un modelo de inteligencia artificial puede correr en miles de computadoras distintas que, al tener la misma base de funcionamiento, pueden compartir de manera instantánea lo que van aprendiendo. Los humanos, en cambio, procesamos el aprendizaje de manera individual y sólo podemos compartirlo a través del lenguaje, lo que resulta lento y complejo.

Hinton advirtió que estos modelos de inteligencia artificial que en un principio fueron creados para tener la capacidad de generar respuestas a partir de una especie de lenguaje predictivo, sin entendimiento, han evolucionado y alcanzado cierto grado de razonamiento que les permite inferir cosas al igual que lo hacemos los humanos. Esto significa que han adquirido una incipiente capacidad de pensar.

Todo lo anterior hizo que las preocupaciones de Hinton se concentraran en dos temas concretos: el primero, ni más ni menos, se relaciona con la supervivencia de la especie humana. Estamos desarrollando una entidad artificial que eventualmente podría superar nuestras capacidades intelectuales (una “superinteligencia”). Se trata de un fenómeno que requiere respuestas que trascienden a los gobiernos y a las empresas, y que amenaza a nuestras sociedades y, por supuesto, a nuestras democracias. Basta con advertir el peligro para la especie humana que conlleva el desarrollo de sistemas de armamentos autónomos (killer robots).

El segundo tema tiene que ver con el hecho de que estas herramientas cambiarán el mercado laboral a nivel global. La inteligencia artificial está reemplazando en muchos sectores a los seres humanos. Ello puede aumentar las brechas de desigualdad. Si a eso añadimos la capacidad de esas herramientas para generar contenidos falsos (videos, voces o textos) que parecen verdaderos, tenemos una fórmula demoledora para la vida democrática: desigualdad y desinformación crecientes.

Una herramienta con esta potencialidad, en manos de un gobierno autoritario, ofrecería mecanismos de manipulación de preferencias electorales nunca antes imaginados. El escándalo de las elecciones presidenciales de los EE. UU. de 2016 —donde, según los datos proporcionados por Cambridge Analytica, las herramientas tecnológicas tuvieron un papel fundamental en el triunfo de Donald Trump— se vería drásticamente superado por las enormes capacidades que tiene la inteligencia artificial generativa en este rubro. México, por supuesto, no quedaría excluido de esta problemática.

Por ello, Hinton realizó un llamado urgente para que los gobiernos emitan regulaciones que prohíban y sancionen a quienes generen contenidos falsos y no informen que fueron creados por herramientas de inteligencia artificial.

“Una herramienta con esta potencialidad, en manos de un gobierno autoritario, ofrecería mecanismos de manipulación de preferencias electorales nunca antes imaginados.”

A principios de mayo de 2023, los directivos de Google, Microsoft, OpenAI y Anthropic fueron convocados a una reunión en la Casa Blanca. El presidente Biden y la vicepresidenta Harris manifestaron sus preocupaciones y recordaron al sector privado su responsabilidad ética, moral y legal por los productos que genera. Las empresas tecnológicas, por su parte, advirtieron sobre la necesidad de crear una regulación que les permita seguir compitiendo y desarrollando sus productos. Y también reconocieron la necesidad de normativas que garanticen la seguridad en esta materia.

Unos días después, el CEO de OpenAI, Sam Altman, compareció ante el comité bipartidista del Congreso de los EE. UU. donde pidió la creación de una agencia gubernamental de inteligencia artificial. En ese mismo sentido se pronunció recientemente Brad Smith, presidente de Microsoft, quien expuso que una agencia de inteligencia artificial aseguraría que la humanidad mantenga el control de esta tecnología. Ambas propuestas buscan un frágil equilibrio entre el desarrollo tecnológico y la seguridad humana.

Se trata de un reto para esta generación. Si no lo enfrentamos con responsabilidad, talento y realismo, puede perder sentido hablar del futuro como lo imaginamos. Y ni qué decir del futuro de nuestras democracias. EP